SMC 資料庫

氣候變遷、生物多樣性、IPBES、鏈結、里山、地景與海景

李光中、孫夏天

議題背景:

《電訊報》(The Telegraph)8月1日報導指出,約11萬筆ChatGPT用戶對話紀錄遭外洩,包含內線交易、醫療諮詢等敏感內容,且已被網站時光機存檔(Wayback Machine)難以徹底刪除。此次外洩肇因於ChatGPT分享功能設計缺陷,使全球各地開啟此功能的對話內容被Google搜尋引擎收錄。

雖然被曝光的對話內容為匿名處理,但許多使用者在對話中上傳含有個人資訊的文字或文件,難以評估隱私資訊的洩漏風險。OpenAI執行長Sam Altman承認,ChatGPT對話可能不具法律上的保密權。即使OpenAI已與搜尋引擎合作移除外洩頁面,但能否徹底刪除約11萬筆已被網站時光機存檔的紀錄,仍存疑慮。

許多人的日常生活已習慣AI協助,台灣科技媒體中心邀請專家提供觀點,說明如何降低使用AI的隱私風險。

專家怎麼說?

2025年08月08日

國立中山大學資訊工程學系助理教授 徐瑞壕

近期,ChatGPT發生重大資安隱私事件,部分用戶與AI的對話紀錄可以被其他人利用網路搜尋引擎檢索到。主要原因是,這些用戶使用了分享對話紀錄分享功能,用戶的對話紀錄被產生成網頁,並可利用網址來分享,只要知道連結的人就可以瀏覽。然而也因為對話紀錄被設定為公開的狀態,所以也可被搜尋引擎輕易的搜尋到,並讓私密對話紀錄在網路曝光。隨著大型語言模型(如 ChatGPT、Claude、Gemini)在日常生活中普及,越來越多人仰賴 AI 來搜尋資訊、規劃行程、甚至決策。然而,這些工具也可能帶來資安與隱私風險,可能造成個資外洩、網路詐騙、甚至操縱錯誤資訊。因此,建議大眾可從以下三方面著手保護自身安全:

一、使用AI時的安全行為

- 避免輸入敏感資訊:商用 AI 平台會記錄任何使用者輸入的資訊,並用於訓練模型,因此含有敏感資訊的AI對話紀錄都可能被AI平台內部人員或平台協作的第三方業者看到。切勿直接輸入身分證、信用卡號、住址或公司機密文件等機敏資訊。

- 謹慎點擊 AI 提供的連結或程式碼:誘導使用者輸入之惡意提示(prompt injection),可能誘使模型輸出釣魚網站或惡意程式碼。若 AI 回覆中包含外部連結,務必驗證來源再點擊。

- 核對重要資訊來源:大型語言模型可能生成「看似合理但錯誤」的幻覺回答(hallucination)。對於財務、醫療、法律等重要資訊,應雙重驗證,或點選引用的真實連結核實。

二、選擇安全的平台與功能

- 選擇有明確安全承諾的平台:可信賴的服務平台會公開安全與隱私政策,例如處理用戶資料方式、是否加密儲存、是否允許停用用戶對話資料被用於訓練等。

- 使用內建安全功能:部分AI平台提供「隱私模式」或「不記錄聊天」選項;也有提供惡意內容過濾、釣魚提示檢測的安全機制,啟用這些功能可降低被攻擊的風險。

- 優先選擇經第三方安全審查的服務:已通過 ISO 27001、SOC 2、GDPR 認證的AI服務平台,或由資安研究單位測試過的工具,具有較高的可信賴程度。

三、長期資安習慣的養成與心態

- 保持警覺與資安素養:學習辨識 AI 詐騙訊號,例如要求轉帳、提供帳號密碼、或承諾不合理利益的對話。

- 定期更新軟體與使用多層防護系統:確保使用最新版本AI的 App、瀏覽器與防毒軟體,並搭配雙重驗證(2FA)、密碼管理工具提升帳號安全。

- 了解 AI 本身存在的限制:LLM 並非全知全能,其輸出基於訓練資料與機率推斷,也容易受提示操控。需要理解這些限制,才能避免過度依賴單一回答做重大決策。

整體而言,降低 AI 使用風險的核心原則是「最小揭露、驗證來源、選擇可信平台」。建議大眾把 AI 作為輔助工具而非唯一決策依據,並持續養成良好的資安素養;而AI平台業者則應加強惡意提示檢測、透明化個資使用政策,並提供即時的風險提示。AI安全需要用戶與平台共同努力,才能在享受 AI 便利的同時,最大程度地保障資安與隱私。

2025年08月09日

逢甲大學資訊工程學系特聘教授 李榮三

生成式 AI 的便利與資安風險,使用者與平台都要更謹慎看待。

近年,生成式 AI 已成為許多人摘要文章、找靈感、解難題、做選擇的工具。然而,就像其他科技產品一樣,生成式 AI在帶來效率與便利的同時,也伴隨著資安與隱私風險。近期多起資安事件便顯示了便利與風險在生成式 AI 的應用中始終同時存在。

其中ChatGPT 與 Grok 的使用者對話紀錄,因分享功能未妥善管控而被 Google 搜尋引擎收錄,甚至包含醫療、法律等專業諮詢內容。雖然平台隨後移除了相關頁面,但透過「網站時光機」等網頁備份服務,仍能找到逾 11 萬筆歷史對話紀錄[1]。

此外,ChatGPT macOS 版曾以純文字儲存對話紀錄,若電腦遭惡意程式入侵,對話內容就有機會外洩,直到事後平台改採加密方式才化解風險[2]。這些案例說明,即使是全球知名的 AI 平台,也難以完全避免資料外洩與駭客攻擊。

這些案例反映,AI 的安全不僅是技術問題,更與日常操作習慣與平台設計密切相關。為了讓民眾與企業更容易落實防護,以下提供「AI 安全使用 3-2-1 原則」作為指引:

3個安全

- 安全平台:優先使用隱私政策清楚、具資料刪除與加密機制,而且訓練資料來源透明(如:不使用可疑或偏見性資料)的平台,可降低資訊偏差與隱私外洩風險。平台亦需在系統設計階段即落實「隱私始於設計」的思維,在源頭就降低隱私外洩風險。

- 安全模式:開啟多重身份驗證 (Multi-factor authentication, MFA)、定期清除對話紀錄、關閉將使用者的內容用於訓練模型的選項。

- 安全對話:機密資料絕不上傳,個資(身分證字號、手機號碼)、工作機密、財務與健康資料都絕不放入對話。

2個正確

- 正確觀念:AI 是輔助工具,最終責任仍然由真人承擔;重要文件應由真人撰寫與確認。

- 正確內容:AI 回答不可盡信,使用前需人工檢查與比對來源。

1 個風險

- 智財風險:避免將 AI 生成內容直接用於營利,因模型訓練資料涉及版權,其商業使用合法性仍具爭議。

生成式 AI 能大幅提升效率與知識獲取,但忽視資安亦可能付出代價。使用者養成正確習慣、平台預設隱私保護,才能在享受便利之時也守住資安。

[1] AI私密對話紀錄可透過Google搜尋被找到: https://www.techbang.com/posts/124682-chatgpt-grok-wayback-machine-privacy

[2] ChatGPT macOS 版應用程式以純文本形式儲存對話: https://www.inside.com.tw/article/35503-openai-chatgpt-mac-version-security-vulnerability-conversations-stored-in-plain-text-content-exposedhttps://www.theverge.com/2024/7/3/24191636/openai-chatgpt-mac-app-conversations-plain-text https://www.panewslab.com/zh-hant/articles/ba57syi7

SMC補充說明:

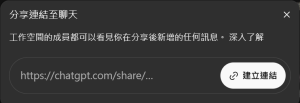

ChatGPT中的共享連結功能,可由對話右上角的「分享」開啟,以SMC的工作空間為例,目前已不見「分享給搜尋引擎」:

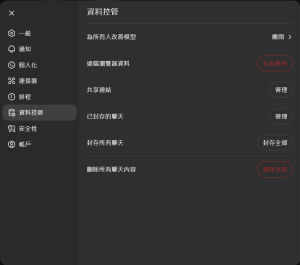

但還是提醒您,您的對話資料是否會被用於模型訓練,以及公開連結資訊,也可以從「設定」中的「資料控管」頁面看見。

版權聲明

本文歡迎媒體轉載使用,惟需附上資料來源,請註明台灣科技媒體中心。

若有採訪需求或其他合作事宜,請聯絡我們:

台灣科技媒體中心

02-7709-5375